LINUX:Drbd

→ retour au menu de la Haute disponibilité

But

Drbd est un équivalent du Raid 1 mais les deux disques sont sur des machines différentes et la synchronisation se fait à travers le réseau. Avec cette pièce de logiciel, on augmente la haute disponibilité. Deux disques en Raid 1 sur la même machine ne nous mettent pas à l’abri d'un arrêt de la machine. Cette configuration est plus délicate et lente mais évite ce cas de figure.

Il est conçu à être intégré à Pacemaker ou équivalent.

Installation

Quelques paquets sont à installer.

dnf install drbd dnf install drbd-utils dnf install drbd-pacemaker

Matériel et adressage IP

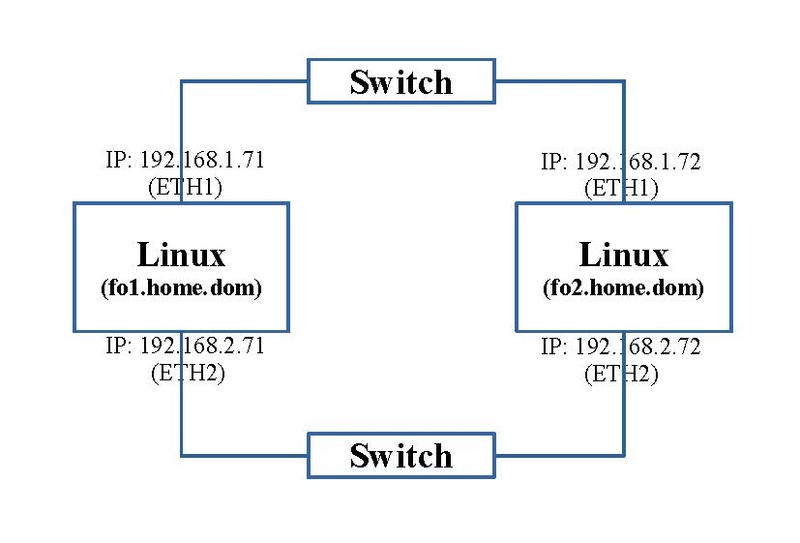

Pour ces exercices, nous avons besoin de deux machines, chacune avec deux interfaces réseaux. Le schéma ci-dessous reprend la connectique, le nom des machines Linux et leur adressage IP.

Sur chaque machine, nous avons besoin d'un disque dur de même capacité; nous avons mis un disque de 160 Gb.

Prérequis

Comme par la suite, on va intégrer Drbd à Pacemaker, les prérequis de l'article sur la Configuration de base de Pacemaker sont d'actualité.

Préparation des disques durs

Il faut maintenant préparer ces disques. Comme vu dans l'article sur les Notions de gestion des disques, nous les préparons avec une seule partition de type LVM ("/dev/sdb1").

Ensuite nous ajoutons une couche LVM. On ajoutons ce device à un Volume Group nommé "fo1_vg_data" pour la machine "fo1.home.dom" et nommé "fo2_vg_data" pour la machine "fo2.home.dom". Ce device est seul dans ce Volume Group. Enfin on y ajoute un Logical Volume qui prend la totalité de l'espace nommé "fo1_lv_data" pour la machine "fo1.home.dom" et nommé "fo2_lv_data" pour la machine "fo2.home.dom". La couche LVM n'est pas obligatoire mais elle permet, si on le désire, utiliser plus d'un disque. Dans la seconde application, nous partirons directement sur les partitions sans couche LVM.

En synthèse, nous avons les devices suivants:

- "/dev/fo1_vg_data/fo1_lv_data" sur la machine "fo1.home.dom"

- "/dev/fo2_vg_data/fo2_lv_data" sur la machine "fo2.home.dom"

→ retour au menu de la Haute disponibilité